最新的加速器提供市场领先的HBM3E内存容量,并得到包括戴尔科技、惠普、联想、超微等合作伙伴和客户的支持

AMD Pensando Salina DPU提供两倍性能,AMD Pensando Pollara 400是业界首款支持UEC的NIC

2024年10月11日,AMD在旧金山宣布最新的加速器和网络解决方案,将大规模支持下一代人工智能基础设施:AMD Instinct MI325X加速器、AMD Pensando Pollara 400网卡和AMD Pensando Salina DPU。AMD Instinct MI325X加速器为新一代AI模型和数据中心设定了新的性能标准。

AMD 首席执行官苏姿丰(Lisa Su)博士展示AMD Instinct MI325X加速器

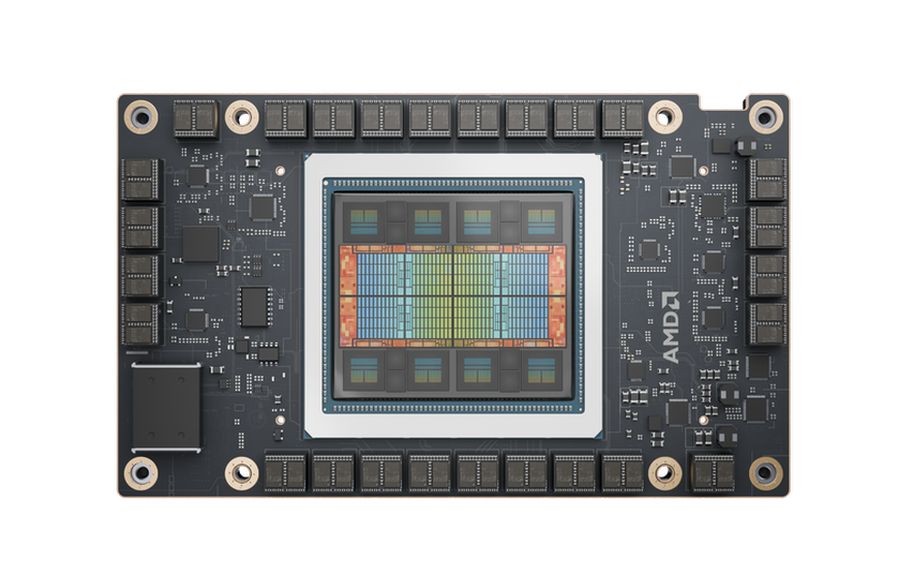

基于AMD CDNA 3架构,AMD Instinct MI325X加速器专为卓越的性能和效率而设计,适用于要求苛刻的AI任务,包括基础模型训练、微调(fine-tuning)和推理。这些产品使AMD客户和合作伙伴能够在系统、机架和数据中心级别创建高性能和优化的人工智能解决方案。

“AMD将继续按照我们的路线图,为客户提供他们所需的性能和选择,以更快的速度将人工智能基础设施大规模推向市场。”AMD数据中心解决方案业务部执行副总裁兼总经理Forrest Norrod表示:“凭借新的AMD Instinct加速器、EPYC处理器和AMD Pensando网络引擎,我们开放软件生态系统的持续增长,以及将所有这些整合到优化的人工智能基础设施中的能力,强调了构建和部署世界级人工智能解决方案的关键专业知识。”

AMD数据中心解决方案业务部执行副总裁兼总经理Forrest Norrod

AMD Instinc MI325X扩展领先的AI性能

AMD Instinct MI325X加速器提供业界领先的内存容量和带宽,256GB的HBM3E支持6.0TB/s,比H200增加1.8倍的容量和1.3倍的带宽。与H200相比,AMD Instinct MI325X的理论峰值FP16和FP8计算性能也提高了1.3倍。

这种领先的内存和计算可以在FP162的Mistral 7B上提供高达1.3倍的推理性能,在FP83的Llama 3.1 70B上提供1.2倍的推理性能,在H200的FP16的Mixtral 8x7B上提供1.4倍的推理性能。

AMD Instinct MI325X加速器目前正按计划于2024年第四季度投产,预计从2025年第一季度开始,将有广泛的平台供应商提供系统,包括戴尔科技(Dell Technologies)、Eviden、技嘉(Gigabyte)、惠普企业(Hewlett Packard Enterprise)、联想、超微(Supermicro)等。

AMD继续其对年度路线图节奏的承诺,预览了下一代AMD Instinc MI350系列加速器。基于AMD CDNA 4架构,AMD Instinct MI350系列加速器的推理性能比基于AMD CDNA 3的加速器提高了35倍。

AMD Instinc MI350系列将继续推动内存容量的领先地位,每个加速器高达288GB的HBM3E内存。AMD Instinct MI350系列加速器有望在2025年下半年上市。

AMD下一代AI网络

AMD正在利用最广泛部署的超大规模可编程DPU为下一代人工智能网络提供动力。AI网络分为两个部分:前端,向AI集群提供数据和信息,后端,管理加速器和集群之间的数据传输,对于确保CPU和加速器在AI基础设施中得到有效利用至关重要。

为了有效地管理这两个网络,并在整个系统中推动高性能、可扩展性和效率,AMD为前端引入了AMD Pensando Salina DPU,为后端引入了AMD Pensando Pollara 400,这是业界首款支持超以太网联盟(UEC)的AI网卡。

世界上性能最高的第三代可编程DPU–AMD Pensando Salina DPU

AMD Pensando Salina DPU是世界上性能最高的第三代可编程DPU,与上一代相比,性能、带宽和规模提高了两倍。AMD Pensando Salina DPU支持400G吞吐量,可实现快速数据传输速率,是AI前端网络集群的关键组件,可为数据驱动的AI应用优化性能、效率、安全性和可扩展性。

业界首款支持uec的AI网卡AMD Pensando Pollara 400

AMD Pensando Pollara 400采用AMD P4可编程引擎,是业界首款支持uec的AI网卡。它支持下一代RDMA软件,并以开放的网络生态系统为后盾。AMD Pensando Pollara 400对于在后端网络中提供加速器到加速器通信的领先性能、可扩展性和效率至关重要。

AMD Pensando Salina DPU和AMD Pensando Pollara 400都将在2024年第四季度向客户提供样品,并有望在2025年上半年上市。

AMD AI软件为生成式AI提供新功能

AMD继续在驱动软件功能和开放生态系统方面进行投资,以在AMD ROCm开放软件堆栈中提供强大的新特性和功能。

在开放软件社区中,AMD正在推动对最广泛使用的AI框架、库和模型(包括PyTorch、Triton、Hugging Face等)中AMD计算引擎的支持。这项工作转化为开箱即用的性能,并支持AMD Instinct加速器对流行的生成式AI模型(如Stable Diffusion 3, Meta Llama 3, 3.1和3.2)以及Hugging Face的100多万个模型的支持。

在社区之外,AMD继续推进其ROCm开放软件堆栈,以最新功能支持生成式人工智能工作负载的领先训练和推理。ROCm 6.2提供包括对关键AI功能的支持,如FP8数据类型、Flash Attention 3、内核融合等。有了这些新功能,ROCm 6.2比ROCm 6.0在推理方面提供了2.4倍的性能改进,在各种大模型的训练方面提供了1.8倍的性能改进。(发自旧金山)