数据中心能耗问题一直是诸多IT部门所头疼的问题之一,对于IDC行业来说,这更关乎企业的盈利,在绿色环保的大背景下,节能越来越成为诸多具有社会责任感的企业所重点关注的问题。IBM中国系统中心作为IBM在亚太地区唯一的绿色数据中心,其PUE值在几年时间内就从原来的1.7以上降至现在最低的1.25,其究竟是怎样做到的呢?在IBM智慧的数据中心开放日中,其向我们开启了绿色节能的大门。

▲IBM 全球数据中心项目总监Allan Hoeft

IBM中国系统中心位于北京市海淀区上地东北旺中关村软件园内,是IBM全球五大数据中心之一,也是亚太区最大的数据中心,也是唯一的绿色数据中心 (IBM认为PUE在1.5以下才符合绿色数据中心的标准)。在这个数据中心内几乎囊括了IBM所有知名的高端硬件产品,如IBM System z大型机Z196、基于Power处理器的小型机,基于英特尔X86架构的服务器,IBM高端存储系统XIV以及IBM DS8800存储系统等。

据IBM全球数据中心项目总监Allan Hoeft先生介绍,IBM全球数据中心能够帮助客户做一些性能、指标和概念模型的测试。IBM中国系统中心是IBM公司在亚太地区唯一拥有Z大机的数据中心,也是唯一能够提供Z大机性能指标测试的数据中心。并且通过IBM数据中心还可为用户展示IBM最新的解决方案和最新发布的产品。

影响数据中心PUE值的因素

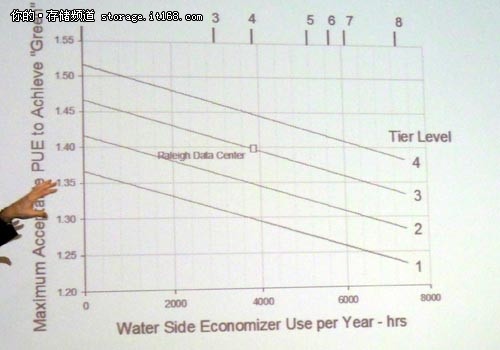

PUE值是衡量数据中心能效的标准,如PUE值为2的话,那就意味着有一般的电力是花费在IT设备上的,另一半则消耗在非IT设备上,如散热、UPS 等。PUE的数值越小,代表数据中心的能效越高。Allan Hoeft先生认为,一般而言,数据中心能效(即PUE值)会受到自然条件(Free Cooling)和数据中心等级的影响。

IBM根据全球不同的地理气候条件,将Free Cooling分为8个等级,1为最热,8为最冷的北极地区,北京的自然条件跟美国纽约类似,其等级大约在4到5之间。通过Free Cooling的作用对数据中心进行散热,在不消耗或者少消耗电力的情况下,可给数据中心能效带来不同程度的提升。

除了Free Cooling对数据中心的能效有影响之外,数据中心本身的安全等级也会对数据中心能效产生影响。安全等级越高,代表数据中心内冗余设备就越多,其消耗的电力自然而然会随之上涨,对数据中心效率产生的影响也就越大。

上图显示为,Free Cooling和数据中心等级共同作用下对数据中心能效的影响。在不同的自然条件下,数据中心等级的不同,其能效也有一个理论值。即无论采用何种方式,其实际PUE值不可能超过这个理论值。例如在北京或纽约的环境下,Allan Hoeft认为IBM数据中心的PUE能够控制在1.35或1.35一下,而对于新建数据中心,PUE值可能有5-10%之间的浮动,在1.38左右;对于改造的数据中心可能PUE值会稍高一些,其PUE值大概会高出20%左右。

IBM绿色数据中心节能措施

一般来说,大型数据中心,尤其是IDC行业,都可以通过优化PUE值来达到提高数据中心效率,降低能耗以节省成本的目的。优化PUE值则有利用 Free Cooling和采用技术手段两种方法。如IBM在美国靠近纽约的Poughkeepsie数据中心,通过直接使用河水来进行数据中心冷却,并辅以必要的 技术手段,使得其PUE值降到了1.19。类似的例子还有如IBM印度的Bangalore数据中心通过大量利用太阳能技术来降低电力的消耗。技术手段则 包括IBM的热交换水冷背板、冷热通道遏制系统等等。而作为IBM亚太地区唯一的绿色数据中心,IBM中国系统中心采用的节能技术相信能够给诸多中国数据 中心带来很好的借鉴意义,下面我们就来简要浏览一下。

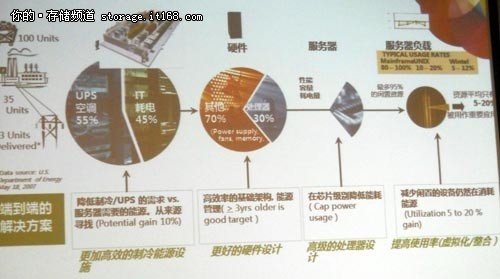

降低IT设备本身的能耗

要对数据中心能效进行优化,首要就要知道能量都消耗在哪些地方。上图是IBM在智慧的数据中心开放日活动中展示的一张图片,通过上图我们可以看到数 据中心的电力大多消耗在了 UPS和散热等非IT设备之上(55%),真正用于IT设备的耗电大约在45%左右。而在这之中,处理器只消耗了IT设备耗电的30%,即使这样,处理器 大部分情况下仍是处于闲置,真正应用到业务的耗电只占小的一部分。这张图的目的在于揭示,在每个环节,不管是从硬件设计、服务器整体设计、机房设计还是系 统管理方面都有很大的空间来帮助数据中心提高能效。

在IT设备节电方面,IBM有着丰富经验和产品,例如Power 7服务器,其可在业务不繁忙的时候进行节电,并有多种节电模式可供选择,例如偏向性能的节电,偏向能效的节电等。并且通过与其他技术相结合,在服务器节能 方面,一台普通的Power服务器可以代替40多台X86服务器,由此可见,不管是在空间、好点、管理还是软件费用上都有较大的提升。

除了在硬件方面,IBM还在软件方面做了大量的功课,例如IBM中国系统中心所应用到的一个叫动态能耗管理软件的产品,其可以通过对业务繁忙度进行 分析,在业务不繁忙的时候,自动将CPU的频率、风扇的转速、所有硬盘的转速以及IUC卡的耗电等都降下去,在保证业务不受影响的情况下达到节电的目的。 据IBM中国系统中心叶华介绍,中国系统中心内的大部分Power 7服务器可以达到20-30%的节能效果,这在大型数据中心内将起到很好的节能效果。

热交换水冷背板——解决数据中心热点

数据中心热点是数据中心内较为常见的现象,由于机房内只能设施或者IT设备放置的位置或者布局不适宜(比如冷热通道设计不合理),或者某些高耗电、 高能耗、高散热量的设备放到了同一个区域,就会出现热点。在这种情况下,通过降低整个机房的温度来解决热点问题明显是不适宜的,那么在这种情况下就需要一 些特殊的技术。

首先我们需要将这些热点找出来。例如IBM中国系统中心内就采用的MMT(移动测量技术),通过这个技术可以做到实时的3D热量分析图,允许管理员在电脑面前实时监控机房内的热量变化。并且通过这项技术还可分析能耗损失在哪些地方,耗电都用于哪些IT设备之上。

在找到热点之后,如果是因为某台设备的由于耗电量大、散热量大造成的热点的话,就可以采用IBM的热交换水冷背板来解决这一热点。热交换水冷背板内部全部采用无缝空心钢管,当冷水流过背板中的钢管直接将这个设备产生的热量带走,以达到消除热点的目的。

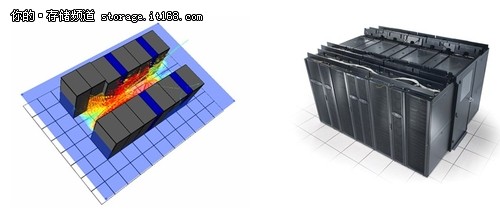

气流遏制系统

这个概念现在说的很多,其实其原理很简单。传统观念认为机房的温度应该越低越好,甚至每个地方的温度都应该很低,但经过美国采暖工业协会及专家测试 发现,只有IT设备的入口温度才是衡量数据中心温度的最为重要的指标,而不用担心其他诸如排风温度等。而气流遏制系统就是将冷空气和热空气分别隔离,来保 证冷热空气不会混合,提供给IT设备最安全、最有效的环境。

气流遏制系统示意图。在IBM中国系统中心内,X86集群服务器采用背靠背摆放,中间通道采用密封设计,这就使得产生的热量不会外溢,影响整个机房温度。并且,中间密封热通道的温度明显要高于整个机房温度,但却并并影响服务器性能

当然,数据中心内的节能措施远远多于上述所介绍的这些技术或者解决方案,例如在IBM中国系统中心参观过程之中,其中还涉及到下送风系统、施耐德公 司去年发布的英飞集成系统、模块化UPS电源等等。叶华也表示,在IBM中国系统中心之内还涉及诸多别的解决方案,例如数据中心监控、机房环境问题以及资 产的管理、系统软件、网络管理等诸多解决方案。正是这些解决方案共同作用,才使得IBM中国系统中心在能效方面有显著提升,绿色数据中心不仅仅是某一项或 者几项技术作用的结果,而是诸多项技术和解决方案共同作用的结果。