人工智能领域有一个怪异的现象:一方面,各行各业都在提人工智能,不提人工智能则代表落伍;一方面,一些真正搞人工智能技术的企业发展陷入困境,前景不被看好。

究其原因,还是人工智能在实际落地中碰到了问题,当我们凑近看这些问题,就能看到存储的重要性。

常被忽视的数据存储

有人分析了人工智能落地难的原因。

认为技术导向的AI技术服务商过于看重算法,忽略了实际需求,同时,定制化的需求也限制了其发展,反而传统企业在AI方面的探索更容易取得成果。

人工智能最早从互联网、金融、安防等领域开始,而后渗透到医疗、工业等领域,还有一些在生命科学、药物研发等领域,以行业为节点,步步为营。

换句话说,都是原来有业务的企业在用AI能力,过程中,需要结合实际场景进行反复摸索、尝试和迭代,而想要加速这一过程,则需要关注人工智能落地的“四大要素”。

数据、算法、算力和模型被认为是人工智能落地的四大要素,其中,算法、算力和模型的话题热度很高,而对数据本身的讨论,似乎也并不是机器学习专家的分内的事儿。

当然,机器学习专家本身对于数据预处理还是很熟悉的,但通常并不了解数据存储的部分,对于存储系统在扩展性、性能、稳定性方面并不在意。

从许多实践来看,AI技术的成功与否,在很大程度上取决于支持数据科学流程的底层IT体系结构。换句话说,想要顺畅地训练、测试和部署AI模型,需要靠谱的计算和存储系统。

AI对存储提出了哪些要求?

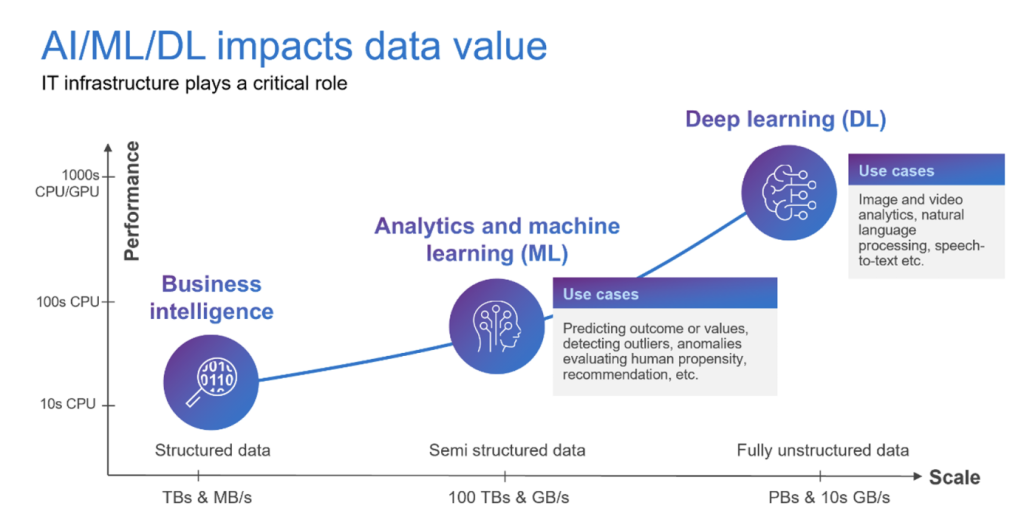

上图来自戴尔的一份白皮书(《适用于AI的IT体系结构:从POC直到生产》),企业用的商务智能只需要少量的结构化数据,需要的算力也比较少,而深度学习则需要PB级的数据,同时,对于计算和存储性能也提出了更高要求。

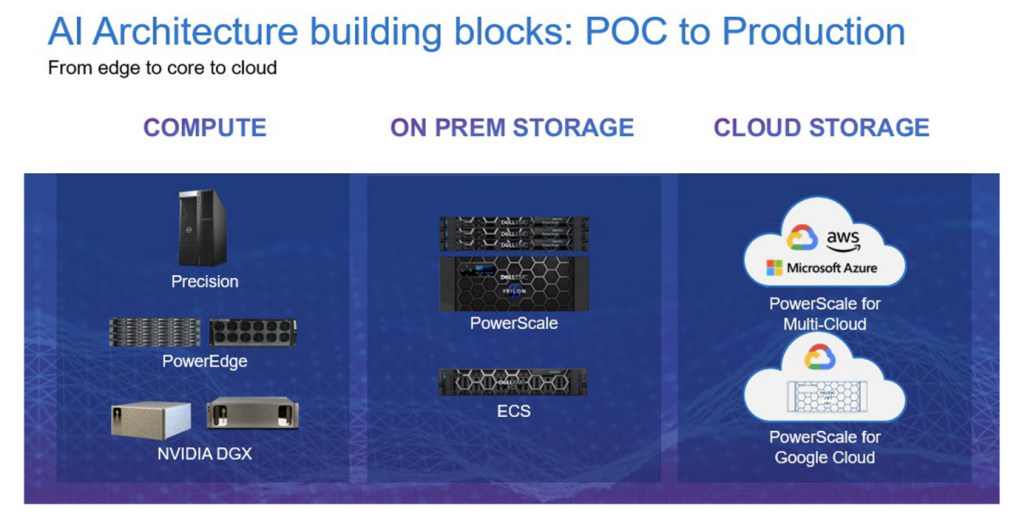

白皮书概括了企业AI项目的落地流程。首先,要搞清楚具体要解决的业务问题,然后,就进入到POC验证阶段,需要将业务问题和数据科学问题来对应,过程中,需要建立一套IT基础架构,IT架构要可以重复使用、可扩展且足够灵活。

众所周知,机器学习的工作过程大致分为四个阶段,涵盖数据采集、数据准备(数据预处理)、模型训练(包含训练、评估、验证)和模型推理四个阶段,每个阶段对于数据存储的要求都不尽相同。

在数据采集阶段,数据可能会从不同来源聚拢并存储起来,数据的大小和格式都存在各种差异,而且,数据类型往往是以文件存储或者对象存储为主,都属于非结构化数据。

采集过程中,首先以顺序写入为主,从多个数据源传入数据,如果存储写性能跟不上,数据就可能会被丢弃,数据的完整度可能会影响模型的准确度。采集完成后,通常还要将收集来的数据放入更大的存储池来进行统一管理,对读性能要求也很高。

在数据准备阶段,需要对不同格式和尺寸的数据进行规范化处理,处理的效率取决于计算以及存储的性能。处理的过程中,通常会有顺序读写、随机读写等操作,在最极端的情形下,甚至可能是各占一半的读写混合。

而在训练阶段,往往需要高性能的GPU或者加速器等来执行一系列的数学运算,对计算和存储资源要求非常高,在做特定训练时,AI训练所需的时间取决于所部署的计算与高性能存储的规模。

推理阶段,对于存储和计算性能的要求会比较多样化,常见的各种边缘场景,在机场和火车站的闸机,在手机的人脸识别系统中,对能耗比较敏感,而在大型模型的推理过程,对于计算和存储性能的要求都会非常高。

总结而言,AI所需要的是非结构化数据存储,并且,对于存储的扩展性、综合性能以及扩展性都有比较更好的要求。同时,由于涉及的数据量会越来越多,对于数据存储和管理的要求也会越来越高。

如果存储无法满足这些要求,轻则影响机器学习训练的周期,影响业务迭代进度,影响企业对于AI战略的信心。重则训练出的模型可能无法用于生产环境,AI计划宣告失败。

戴尔帮助企业将AI落地

戴尔能为企业的AI体系结构构建从边缘到核心再到云的数据环境,计算部分有Precision工作站、PowerEdge服务器和NVIDIA DGX服务器,而存储部分则有PowerScale横向扩展存储和ECS对象存储,其中,PowerScale还可在云端部署。

PowerScale的非常适合存储用于AI/ML/DL的大型数据集,服务于机器学习和数据分析场景。

PowerScale的高性能、高并发性能可满足机器学习从数据采集、数据准备、模型训练和模型推理各阶段对存储性能的要求,能更快完成AI模型的训练和验证。

PowerScale的可扩展性,使得从POC验证到生产环节的所有数据都可以存放在PowerScale上,而且可以随着数据量的增长随时添加节点来扩容,从而可以避免费时费力进行数据迁移。

PowerScale提供丰富的企业级特性,它能将数据管理、性能管理、数据保护和数据安全有机地整合,从而提高数据存储的经济性,降低拥有成本并减少风险。

PowerScale还提供了高效的管理能力,借助PowerScale自带的数据管理工具 Dell EMC DataIQ,任何人都可以轻松地在跨本地和异地部署的,文件和对象数据平台上查找和管理数据。

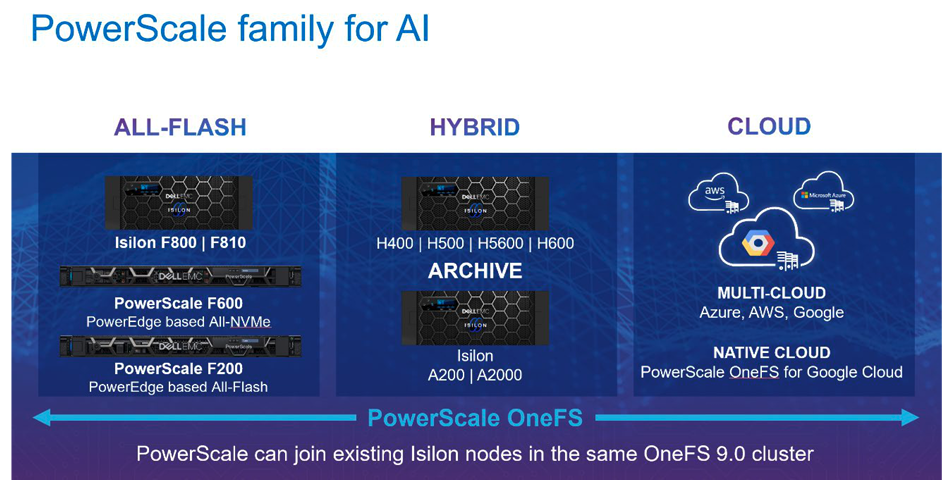

PowerScale既有全闪存配置,也有混合存储和归档存储配置,满足用户在性能、容量和成本之间的平衡,还与谷歌云、亚马逊云以及微软Azure合作将数据放到云上,利用云上的弹性资源进行机器学习的训练和推理,为企业提供了丰富多样的选择。

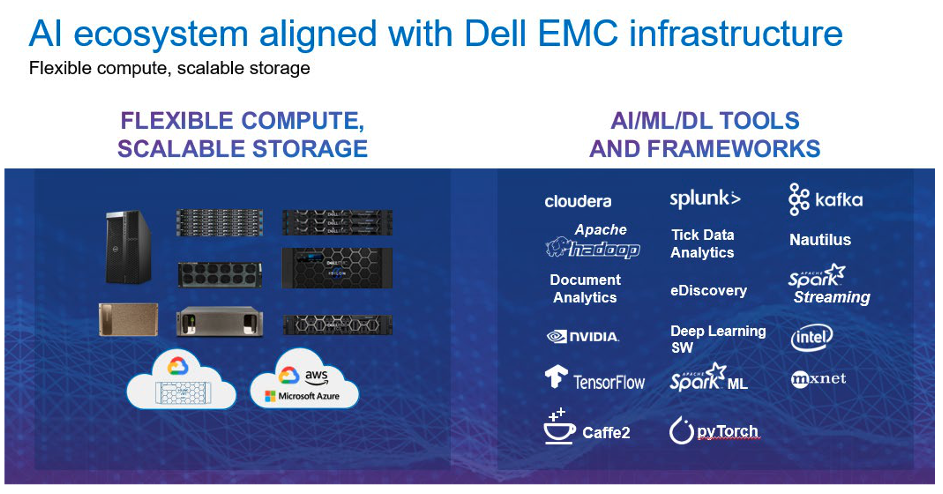

此外,戴尔不仅提供了种类丰富的IT基础架构,拥有多种参考体系结构以及经过验证的计算和存储解决方案,还提供了常用的AI/ML/DL工具和框架,包括大数据分析平台Splunk、机器学习框架Caffe2、TensorFlow、PyTorch等,让机器学习的流程更顺畅。

结束语

可以说,戴尔存储不仅能满足机器学习各个阶段,对存储在性能和扩展性方面的要求。而且,还有可用于构建服务于AI工作流的一整套IT基础设施,更能将企业所需的安全、高效数据管理能力带给企业,是企业构建AI能力的理想之选。