如果对Dell EMC PowerScale稍有陌生,它还有一个大名鼎鼎的名字叫Isilon,分布式文件系统,适合PB级海量数据文件的存储集群,IOPS可以达到1580万次/S,性能相当的强劲。

Isilon扬名立万是在石油勘探的应用中,配合高性能计算机应用,解决海量文件系统并发访问的问题。如今,就是这样的一款产品,与Cloudera联系在一起,通过了Cloudera Data Platform私有云版本的质量控制测试套件(QATS)认证。简单说,不论是使用Cloudera Data Platform(CDP)的用户,还是此前使用Cloudera Data Hub或Hortonworks Data Platform升级到CDP的用户,Dell EMC PowerScale都是经过认证的存储硬件选择。

看似就是一个软硬件商业合作,但其背后传递出来的信息并不简单。

也许您也并不熟悉Cloudera,但您一定知道Hadoop,大数据,Cloudera就是Hadoop、大数据的代名词。

对于Hadoop,最初的认识是MapReduce、建模和处理,主要用于大数据分析。不同于传统OLAP((Online analytical processing,联机分析处理)数据分析,大数据强调全量数据分析,洞悉大量结构化、非结构化数据背后的奥秘。

但是对于多数用户来说,Hadoop是一个比较复杂的系统,数据建模更是一个难题,这就在一定程度上制约了大数据技术的应用推广。

传统Hadoop建立在通用x86服务器硬件基础之上,强调数据贴近计算,这就是大多数人对于Hadoop、大数据的印象。

如今,Hadoop与PowerScale联姻,这又意味着什么?有会带来哪些机遇和变化呢?

要说明这个问题,我们要意识到大数据的价值不在Hadoop系统本身,真正的价值还在于数据分析结合业务创新,以电商应用中的个性化推荐、金融发欺诈应用为例,他们都创造了新的业务价值,但是可惜的是,这样的业务应用创新并不普遍。

关键还在于数据分析。实际上,围绕着Hadoop分布式数据库存储的基础,CDP也提供了大量的数据分析工具,其中包括:HDFS、Hive、Spark、HBase、Imapla、Kudu、Ranger、Atlas、Kafka等,涉及数据仓库、列式数据库、内存数据库、列式NoSQL数据库等,也包括分布式消息、元数据管理、数据安全访问管理和监控等企业级应用的需求。

您可能并不擅长Hadoop、MapReduce和数据建模,但是当您使用Hive、HBase、Impala、Kudu这些数据分析工具的时候,您是否意识到了,您正在应用大数据。从这个意义上说,Hive、HBase就是大数据。

如今,围绕着数据创新,数据中台、湖仓一体、Lakehouse等概念备受追捧,从他们的视角也支持Hadoop大数据,大数据似乎只一个更小的子集。但是从大数据的角度出发,并非只有Hadoop,也支持数据仓库、列式数据库等数据分析工具,而且有多种工具可供选择,如Hive、Impala都可以简称为数据仓库,但是他们技术特点不同,适用的场景也有所不同。

大数据不仅支持数据仓库,同时也支持数据湖,支持的硬件不仅有Isilon并行文件系统,也支持对象存储为基础。

如此看来,条条大路通罗马,水流千里归大海。数据中台也好、湖仓一体也好,大数据也罢,技术上其实是殊途同归,没有最好的,只有最适合的。如果您熟悉Hive、Impala等,大数据就是最好的选择。

如果您关注企业级安全管理和监控,重视企业级数据容灾,专业存储如Isilon、ECS对象存储就是上佳的选择。

相比x86通用服务器方案,选用专业存储作为硬件支撑还有一个好处,就是存算分离的扩容,系统架构更加灵活和方便。不仅如此,质量控制测试套件(QATS)认证还意味软件层面的深度优化和融合。

这种融合带来的性能和效率提升是显而易见的。

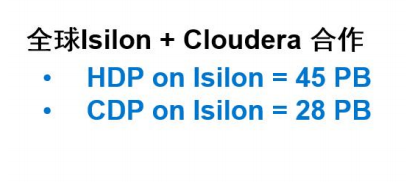

实践证明,全球运行在Isilon上的HDP、CDP数据,高达45PB、28PB,如果您熟悉Hadoop,或者熟悉Hive、HBase、Impala、Kudu等数据分析工具,选择Isilon何乐不为呢?

这才是PowerScale通过Cloudera最高级别认证的价值和意义!

对此,您洞悉了吗?