新年伊始,各种预测展望如期而至,但真正精彩的并不多!

恰如《连线》(Wired)杂志创始主编凯文·凯利说的 “即将消灭你的人,今天还没有出现在你的敌人名单上。”可见预测是一件非常困难的事情。

如果是预测不过是凑个热闹,与之相比,判断则要严谨重要得多,因为它是决策的基础。以软件定义存储、全闪存阵列、传统存储为例,将如何选择呢?

这真是一个问题。

云厂商是怎么选的?

相比,软件定义存储,传统存储,有谁可以一统存储市场江湖吗?

我们期待这样的一个结果,从而减轻选型中的困惑?

关键就在于软件定义存储,

软件定义存储会成为存储市场的主流吗?

答案是肯定的!

在2018年存储与数据峰会上,浪潮存储给出了明确的答案。

浪潮存储的信心来自哪里呢?

当今市场的用户环境是一个多云状况,从边缘(Edge)到核心(数据中心)到云(Cloud),从私有云到公有云,到混合云,从一个公有云,到另一个公有云,这就是目前典型的用户应用的场景。根据IDC提供的数据,2018年云计算基础设施的规模为523亿美元,未来会按照10.8%复合年增长率(CAGR)增长。

如果说,传统行业企业用户的云化还在路上,没有那么清晰,不妨看看公有云厂商的选择。

在公有云的世界里,软件定义存储早已经一统江湖了!

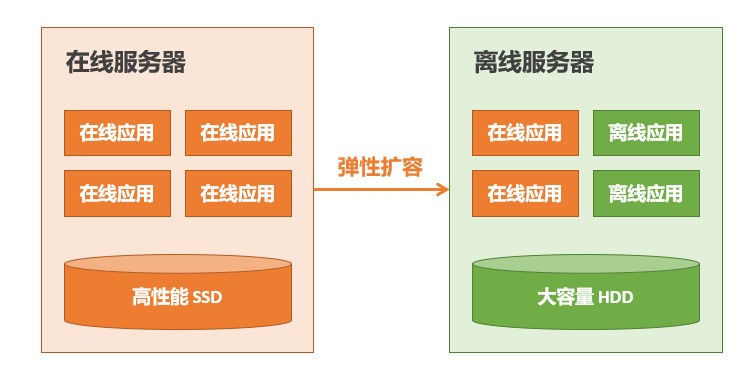

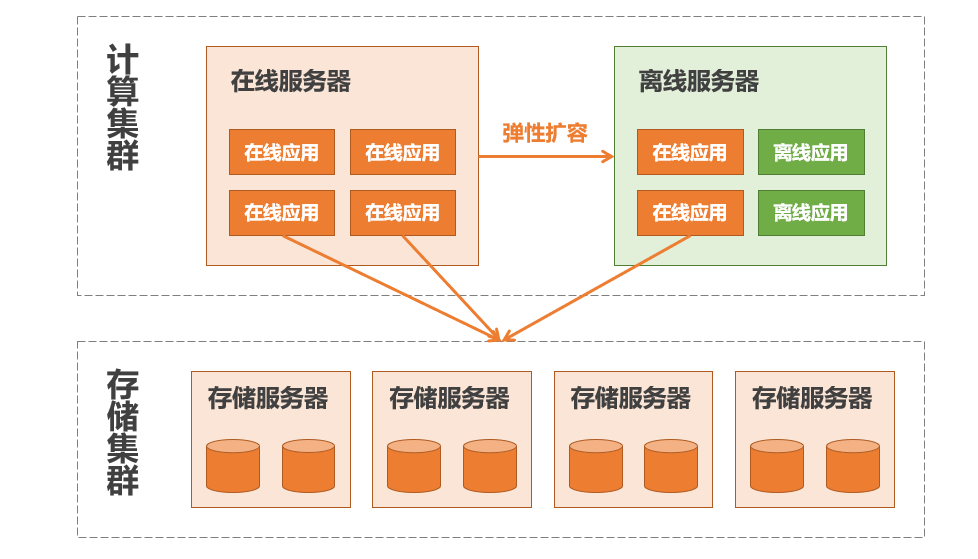

公有云厂商为了应对“双11“的业务尖峰,唯一的办法就弹性扩容,短暂利用离线服务器的资源,但是传统的架构和资源配置,依靠直连存储DAS,特别是HDD的性能瓶颈,带来的问题显而易见。

存储计算分离,构建统一的软件定义存储集群,这就是问题的答案。

传统行业市场特殊吗?

既然如此,在传统行业企业市场,为什么这种现象没有发生呢?

就连“软件定义存储“本身,也是EMC等存储厂商最早提出的,当时的概念,强调软件、硬件的解耦,这也是软件定义的存储。

如此原因,还要从应用寻找答案。

从应用软件现状看,互联网企业以云原生应用为主,具有非常好的分布式设计,与软件定义存储珠联璧合。相比传统行业企业,应用以传统应用为主,不具有分布式特征,这样的应用可以构建在软件定义存储的基础上吗?可靠性,稳定性,安全性可以媲美传统磁盘阵列吗?

这也是传统行业企业所担心的,也是困扰他们的难题。

要么向互联网企业学习,对于传统应用进行云原生改造,显然这是一个艰巨而漫长的过程,此外,目前技术基础,人才积累也限制了云原生花改造的进程。

怎么办?

答案是:软件定义存储产品自身能力的提升。

目前市场上,软件定义存储产品众多,有开源的方案,也有自主研发的产品。其中,开源产品也有Ceph、SheepDog、MooseFS、Swift等多种方案选择。用户可以选用开源社区版本,也可以购买开源商业版本。自主研发产品方面,VMware、浪潮、华为、联想、新华三、紫光西部数据等也推出了自主研发的软件定义存储产品,IBM、DellEMC、NetApp、Ventara、Nutanix等也推出了相应的产品方案,此外,XSKY、SmartX、华云网际、凯翔、南京鹏云等国内创新企业也推出了各自的产品解决方案。

在如此众多方案中,如何进行选择?

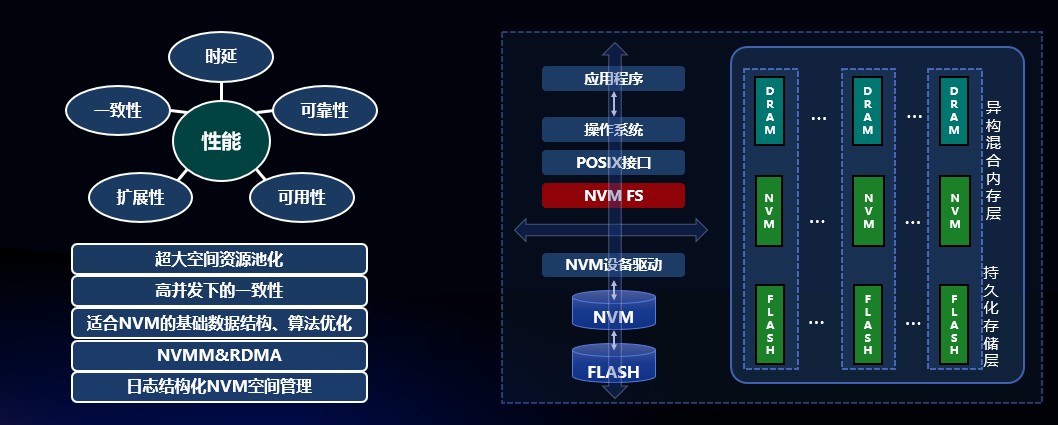

对此,首先是技术的选择,亿级IOPS、百GB带宽、EB级海量存储空间、千亿亿文件管理等硬件指标是一个衡量的标准。

软件定义存储选型“硬标准”

如此优异的产品真的现实存在吗?

以亿级IOPS为例,这不是简单的 SSD置换就能够实现的,涉及从介质到算法优化,从外部存储到内存计算的设计和优化。借助NVMe SSD、3D XPoint SSD等固态存储介质技术,通过全闪存软件定义存储内的介质更新,软件算法优化,大幅提高IOPS、时延和带宽。

在内存计算技术发展起来之后,在数据库设计、应用设计方面已经得到改变,固态存储介质技术的引入,也为内存计算增加了非易失的特性,让计算和存储的特性得到极大发挥。

为实现亿级IOPS,需要从底层NAND FLASH、NVM(Non-volatile memory,非易失存储器)、设备驱动,接口、操作系统、上层应用程序等软件协议栈进行全面的优化,从应用系统的层面,对于NVM存储介质管理、控制、质量保障、数据保护进行通盘的考虑,这是实现存储高性能的关键。

与此同时,一些大型的集群,IOPS并发性能要求达到了千万级。以AI为例,它是建立在大量原始数据基础上进行的,其原始数据经过标记后,会变成大量的小文件,规模通常达到百亿级。

以Tesla V100GPU应用为例,每个GPU用5个容器读取文件数据,每秒钟约产生5000个OPS,每个OPS按三次操作计算,如果,每台设备有16个Tesla V100GPU, 16台设备搭建一个集群,总计256个GPU,对存储的IOPS性能要求,就达到了400万。

为了应对如此规模的应用访问,要求软件定义存储具有非常好的横向扩展(Scale-out)能力,以浪潮AS13000软件定义存储为例,不仅可以可扩展至5120个节点,同时,通过数据自动修复和自动运维机制,完全可以适用于海量数据存储场景。浪潮AS13000软件定义存储,一套架构实现了文件、块、对象和大数据场景的数据服务。

从实践中来

以类似浪潮AS13000软件定义存储产品作为基础,对于行业企业用户来说,完全可以像互联网企业一样,快速实现业务的云化,借助软件定义存储的横向扩展能力,从而满足来自互联网的用户访问所带来的压力,缓解资源弹性不足的问题。

其中,软件定义存储的场景化能力至关重要,也是解决传统行业/企业问题的关键。

以石油勘探为例,借助对海量地震波数据的计算、解释和反演,从而模拟出勘测区域的地下构造,并作为钻井精确定位的依据,重要性和经济效益显而易见。如今,三维地震数据处理、解释一体化软件应用对存储空间初始需求就达到PB级别,项目平均数据增量达20TB,一般单文件大小也都在200GB左右。

以往, 54TB原始勘探数据通过4000个CPU计算集群、GB级带宽的存储集群处理需要50多天时间。为缩短处理时间,就需要优化数据存储和计算平台,通过增加GPU来进行加速,与此同时,要求软件定义存储进行了大量场景化调优。

浪潮软件定义存储AS13000通过去躁、振幅补偿等多项作业的优化配置,提升了批量作业的处理能力;通过目录分片,也就是在元数据服务端将目录分成同等地位的多个分片,由每个分片承载该目录下的不同子文件,如此,才能够通过提升并发能力,满足石油勘探大目录操作性能的需求。

如今,浪潮软件定义存储AS13000可支持单目录千万级文件、文件系统可达百亿级,百万文件浏览时间突破40s。

视频监控智能交通领域,需要对海量图片进行查询,要系统能够满足“秒开”的能力。从技术上,涉及视频监控信息的海量存储,要求系统提供海量存储能力,以一个120个视频监控探头线程13.08小时所产生的数据,会涉及556万个文件的写入。在这个基础之上,还需要提供“秒开”查询的能力。

为了满足这样的需求,一方面需要利用多节点数据并发读写的能力;另外还要考虑元数据服务集群技术,满足百亿级别文件的快速检索需求。在成都视频监控智能交通的项目中,以AS13000软件定义存储为基础,浪潮成功将图片检索用时,从十几秒降低到3秒以下,实现交通监控图片取证“秒开秒解”的创新需求。

从现有的行业实践来看,软件定义存储并不是一个放之四海而皆准的通用性技术,需要产品服务提供商能够根据应用场景的特点,对软件定义存储产品的技术功能加以组合,如此才能够满足产品的需要。

小结

毫无疑问,云计算是未来行业发展的趋势,而软件定义存储的特点与云计算无缝衔接,是行业用户未来的主要选择。随着云计算普及,软件定义存储超越传统存储是指日可待的事情。

应该说,云计算的着眼点并不是针对某个特点应用,云计算强调的是基础设施,讲求的是资源池化,追求系统的弹性,强调资源应用的效率。但是从单一业务应有的眼光看,除非采用公有云应用,否则云系统的经营、管理和服务,还是一个复杂的事情。如果不考虑效率的问题,只从单一应用的角度出发,传统存储解决方案其实拥有最佳的案例实践,仍然是用户最佳的现实选择。

从这个意义上说,传统存储市场仍然有所发展,但从长远的趋势看,让位于软件定义存储将是必然的趋势。