当今科技爆炸时代,软件定义存储,超融合等术语浪潮一波接一波,大家开始跟着这些所谓的行业热门趋势“随波逐流”,往往将自身实际情况抛诸脑后,响应趋势号召,唯恐落于人后。这逐渐使得选择软件定义存储,超融合成了一个不得不正视的问题。

12月9日,以“新存储,新常态,新应用”为主题的中国存储峰会于北京悠唐皇冠假日酒店召开。下午超融合技术论坛上,英特尔(中国)有限公司存储架构师,陈小波在发表的主题演讲《英特尔助力软件定义存储导航》中指出,存储运用数据,数据是用户最核心的IT资产,要求存储安全可靠,稳定运行。存储要求性能,IOPS,bw(带宽,每秒的吞吐量)、lat(每次IO操作的延迟)。而应用产生数据,由应用来牵动你的软件定义存储或者操作各方面的存储。

以下为陈小波演讲实录整理:

英特尔(中国)有限公司存储架构师陈小波在会上以EMC是否为软件定义存储一问引题,“EMC不是软件定义存储,确实不是,但存储其实都由软件来控制。”

济南海关工程师分享了其选择SDS的经验

何为软件定义存储,何为对用户最有用的软件定义存储?相信大家看完济南海关高级工程师孟凡超的分享之后会有一个初步的认识。

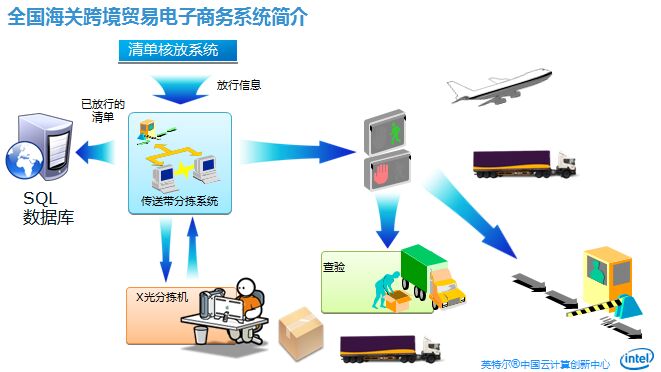

孟凡超首先介绍了一个今年制作的全国海关跨境贸易电子商务系统流程图,为国内货物出口国外的基本流程。最左边的SQL数据库,最早之前是在存储上,通过画LINE的方式放置SQL数据库。运行发现的问题主要集中在数据量较大——济南海关一年报关单与抄单数为15万份,加上它所有环节上的单量在70-80万之间。

再加上现在还启用了新一版的报关机制——无纸化报关。所有中间环节都以电子数据形式存储在网络上。

接下来的审单各个环节也通过读取网络上电子数据完成。这相当于海量存储,用户读取或检索需要很高的IOPS支持。而如果一票货物都装在一辆车里,卡口放行时由于需要读取所有货物所有报关单的信息,后台SQL数据库性能造成了一个瓶颈,用户读取单量的时候,产生很高的延时。里面放着数十份报关单,放行的时候,车行走卡口的位置,摄像头取得他的车牌号之后,把后面所有报关单的信息全部给同步出来,看他的信息是否符合放行标准。

这个时候经常有一个现象——我这个车上到台上去,需要等到很长时间,前面那个杆才抬起来。这个过程我们经过排查之后发现,确实对于我们通关来讲效率低了很多,从今年开始我们也对整套系统进行了一个从头到尾的排查,终于排查出来之后主要性能落在SQL数据库上。

下一步我们通过最早之前SQL数据库是用的2008版,做的是Windows自己带的故障源集群。性能大家知道基本上是平时用的话只有一台主机用,另外一台是待机状态。我们今年做了一个新的,就是用了SQL2012,有一个Alwayson集群。我有三台主机,其中有两台它的数据库是处在同步的状态,这个时候它的硬件应用率和原先2008的方式应该是利用率提高了。下面介绍它的性能来讲是中间同步的关系,第三台机器做了SQL一个异步的同步,对我的数据库有三个副本。

这个过程当中,从一般传统技术上来讲,可能你要在主机下面挂的是存储,今年我们采用的是本地磁盘。通过三台主机安装英特尔的PCIE SSD卡,做了一个数据库整合,我把我的主数据库都放在SSD上。我们再去测性能,发现延时基本被消除。这个系统运行一年之后,我们用NVMe和FC-SAN,性能提高5倍以上。原来半分钟时间把数据从后台读到前端去,现在5秒左右就可以抬杆。之前计划购买两套FC-SAN,后来买了SSD卡把这个问题解决了。后来容灾都没有单独再去购买。运维成本少了两套FC-SAN存储,包括机柜,耗电,空调,机房占用都节省掉,对人力成本也减少很多。因为我现在不太需要维护FC-SAN关键存储,只需要维持它的正常运转。

这个系统我们目前来讲能够对我们整套通关多元系统起到很好的支撑作用,虽然说中间可能没有什么很好的创新,但是我们融合了几种产品的优点,能够将它用于我们自己目前所做的工作。

我的汇报就到这。

应用软件是定义存储的关键

陈小波:说到存储我们看它的特征,所有存储从硬件来说就是两块,一个控制器,一个和控制器相连的磁盘。从软件应用控制器上,软件做什么?软件高度抽象之后就三个作用——组织磁盘、输出磁盘、容灾。

存储要做什么?存储运用数据,既然是数据就是用户最核心的IT资产,要求存储安全可靠,稳定运行。存取要求什么?要求性能,IOPS,bw(带宽,每秒的吞吐量)、lat(每次IO操作的延迟)。应用的数据,刚才济南海关说的很清楚,谁产生数据?应用产生数据,由应用来牵动你的软件定义存储或者操作各方面的存储,使得你的应用从用户层面看待整个核心。

数据中心面临的五大问题——安全,可靠性,性能,易管理性和成本

传统数据中心面临的问题。基础硬件发展决定就是高效利用CPU多核,这是绝大多数用户数据中心里面的环境,有一些单独应用和数据库在物理计算。对用户来说比较普遍的几个问题,性能是一方面,但性能不是最绝对的一个方面。很多大型用户性能主体不严重,不严重的前提条件是他付出了非常昂贵的成本实现性能无虞。如果存储性能不够会是什么情况?我们有一个案例,一家公司买了32位的Oracle数据库,三套数据库要求10万的IOPS,存储只能给3万。大家知道Oracle是根据日志浪费,浪费钱不说,它的业务也受到了影响。存储性能不够,造成你整体应用性能不够,不仅仅是存储的问题。

同时在新的数据中心逐渐走向虚拟化和云化的时候,你的存储和虚拟化和云的结合是不是足够的敏捷,足够的弹性,这些是传统的FC很难回答的问题。

从最终用户角度来讲,数据中心基础架构来讲始终是计算、存储、网络这三块。每次由计算推动整个发展,现状就是整个计算从小机走向IE架构,也从IE架构里面走上虚拟化和云化。技术推动这个,要求存储和网络跟上这个。存储性能直接影响你的整体性能,大小用户都受限于存储性能。他们直接推动之后,形成新的平衡,以达到形成统一管理。

最终用户需求是什么?他们会说,我不关心你们很多需求,我就关心第一我们的数据是不是安全的。数据安全是基本的要求。现在大家都知道整个超融合和SDS市场蓬勃发展,看上去都很好,谁是真正的好,谁是真正在保证我的数据安全,这是用户的疑问。用户填的第二个需求是简单易用。这几点用户对几个基础架构追求统一起来,我们换成一个公式,如果你的安全有一点瑕疵,不管你前面性能多好,界面多么炫目,得分是0。我们有各种安全保障,系统稳定可靠,不会因为单点故障失效,有容灾等等,这是系数能否保证100分的算法。

传统终端存储,两个控制器互相作用,提供SCN的接口,这是大家最熟悉的存储形态。这种形态下,绝大部分厂家Gateway,能提供一个ISCSI,NFS和SMB协议,统一存储。可能也是终端存储的一个定义。

如果我们把控制器加多,磁盘加多,四个或者八个控制器,这是高端存储。本质来讲它和终端存储一样,只是控制器更多,整体能力更强一点。传统盘在传统架构不变的情况下,从机械硬盘换成SSD。各种架构都有,绝大部分都是这样。这里有一个问题,控制器能力,软件定义存储,任何存储都是这样。

组织磁盘、输出磁盘,组织磁盘第一我有各种技术,把盘组在一起提供,控制器这时候是瓶颈。我们把控制器拿出来盘减少,以前通过外设盘柜就放在控制器里面。用各种方式把它们连接起来,这个时候就叫分布式存储,最早常见的分布式存储。云存储、对象存储,传统存储无法提供海量数据的弹性扩展。

大家一说分布式存储,主要是在互联网为主提供的对象存储上,云盘上,这比较廉价,为了降低成本,不一定用服务器,甚至用i3和i5的CPU。大家在日常工作中超融合,这个地方你不要受廉价PC的误导,它不是干这个事的。广义上讲,所有的ServerSAN,HCI,Object都是分布式存储。

大家都知道存储里面的计算资源不多,如果我们再把两个合并起来就是超融合。话是这么说。英特尔展台有七家,外面神州云科他们展台上有一个测试规范。其中有一项就是你用多少资源达到多少性能。有几个指标,其中一点就是用很少的资源实现一个相对较高的性能。你把本该用于虚拟化的计算资源和内存资源用于你的存储,这被认为是失败的超融合。我们只计算节点里面少量计算资源和内存资源。

大家都有一个想法,对于不同的应用,它们对于性能、成本、可扩展性、敏捷性的要求不一样。比如云计算非常要求敏捷性,数据库其实不太要求敏捷性,数据库要求极限性。在我们分布式存储里面它的原数据怎么设计,要求不同。大家想用一种技术去实现是有困难的,甚至大家强求分布式,其实有时候并不都需要分布式。刚才济南海关孟凡超讲的,单机用的就是本地的软件保护技术,软件定义的软件保护技术。整体两地三中心,用的不是分布式软件,是整体的两地三中心全闪的数据库解决方案。性能、成本各方面的解释,不一定需要强求。

组织磁盘,用于云的超融合可以在更高层面。输出,在超融合,不管数据库超融合还是云的超融合有一点很隐含的优势。只输出给本机,减少它在设计和性能上的拼接。更高层面由别的软件进行,不管是HAA+DR的设计。最早是数据库要求的,原来不完善,现在数据可以做到。其实Oracle也可以做到。

再简单讲两点,最核心的两点,数据安全和性能。安全主要矛盾是软件,硬件也有要求,有各种的容灾方案,主要矛盾是软件。我们测试也是软件,是一切的前提。他担心出问题,成功案例很重要,测试方法很重要。核心来说,就是在虚拟机中跑数据库,各种破坏性测试。通过我们这个测试,它一定没问题。在我这测试8台、16台的规模,他实际是32台,有的问题在小规模爆发不出来,大规模可以爆发出来。

简单说怎么测?两个数据库不停的查数据,跑FIO,给它数据量。做各种破坏性测试,拔网线,关机等等破坏性测试。应用不停顿,关机应用肯定会停顿,我的所有都是好的。

性能主要矛盾是硬件,不是软件。软件厂家之间的区别就是一个打罗汉拳,一个打太极拳,打的好的都一样。硬件决定你性能的基础,我给你100分性能,软件决定把这个性能发挥60分还是40分。软件设计的好与坏,40和60分的差距很大。任何性能上的投机取巧会付出数据安全的代价。传统存储上,比如EMC是靠UPS去保证内存中的数据库,如果说它没有相应的保证,我不相信谁有几百个、上千个存储节点的UPS。如果它没有各种措施,任何想在性能上投机取巧,用户一定会扶持血淋淋代价。

磁盘转速决定你的Random性能,RPM还能磁密度上升,容量还能提高,现在是8T,16T,32T,你即使性能提升了,你的rebuild,在容量增加后数据安全性也会很危险。怎么选?我看可靠性。可靠性第一,数据库大家经常考虑性能,其余可以考虑性价比。

解决方案和结论,第一软件,选适合你的软件,用合适方法测试它们。这也符合二八定律,不会百分之百都落在SSD里面。

除了英特尔还有软件,英特尔还用于OPA。大家对英特尔的OPA感兴趣请联系我们。谢谢大家。