挑战:安装和优化剑桥大学Linux 集群 InfiniBand网络的性能,及时完成LINPACK基准测试,并且需要在截止日2006年11月前进入世界500强超级计算机名单中。

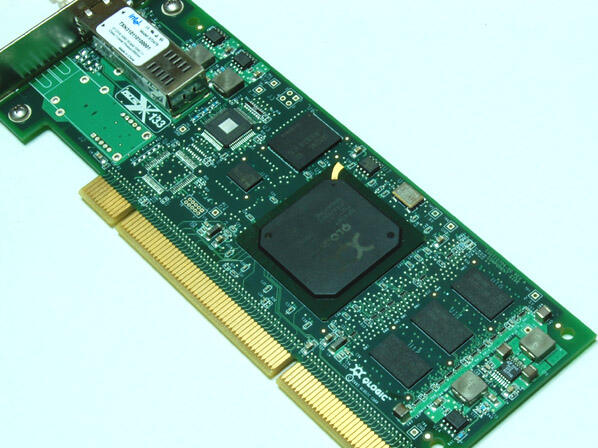

解决方案:HCA卡:585块 QLogic InfiniPath QLE7140 PCI Express 主机通道适配器;交换机:SilverStorm多协议交换机(Qlogic于2006年11月收购了Silverstorm Technologies公司);服务器节点:585 台Dell PowerEdge 1955 双核3.0 GHz Xeon处理器。最终的9个65节点的计算单元组成的集群能够达到27TFlops的运算能力。

结果:拥有超级计算机的性能,同时,拥有成本远低于传统超级计算机;剑桥大学高性能计算机集群的运算能力在英国排名第2位、欧洲排名第7位,全球超级计算机500强排行榜上排名第20位。

剑桥大学超级计算机位列Top500 第20强

剑桥大学的高性能超级计算集群入选2006年11月全球超级计算机500强排行榜第20强,是全球最具实力的超级计算机之一。Top500组织采用业界标准的Linpack测试,在剑桥大学超级计算集群取得超过18万亿次浮点运算(TFlops)的运算能力。 http://www.top500.org/list/2006/11/100

剑桥大学集群系统也被称为“达尔文”(Darwin),是一个基于Linux的HPC集群,包含9个计算单元(CU)。每个计算单元是一对机架,包含65个DellPowerEdge1955计算节点。这些节点都与一个核心的通信机架相连接。Infiniband网络互连设备包括585块QLogic InfiniBand QLE7140 PCI Express 主通道适配器(HCA)卡, 9台作为边缘交换机的96端口QLogic SilverStorm9080 Infiniband交换机(每台连接65个计算节点),和1台作为内部互连的核心交换机QLogic SilverStorm9240多协议导向器交换机。

剑桥大学选择QLogic

剑桥大学的超级计算机具备每秒处理超过27万亿次浮点运算(TFlops)的能力,为剑桥大学对复杂的分子结构、宇宙和地理学等方面进行日常的模拟分析提供了充足的”计算马力”。为了达到这样的处理能力就必须解决集群在互连方面的瓶颈。这就是剑桥会选择QLogic的InfiniPath InfiniBand主通道适配器(HCAs)和QLogic SilverStorm InfiniBand交换解决方案的原因。对比于目前所有能够采用的集群交换解决方案,QLogic InfiniPath HCAs能够提供业界最低的计算延时(Lowest Latency)、最高的信息传输速率(Message Rate)和最大的有效带宽(Effective Bandwidth)。

QLogic SilverStorm 多协议交换机和导向器具备低交换延时、高带宽结构同时用户可以通过Infiniband协议无缝的连接存储设备和以太网网络。此外,QLogic SilverStorm交换机的架构设计具备很高的可扩展性,保证了剑桥大学集群的升级空间,同时大大减少了网络的成本和复杂性。

剑桥系统运行LINPACK基准比预期时间早了4小时

在完成了最初的集群安装和调试,马上进行的是LINPACK测试。LINPACK基准测试是500强组织衡量高性能计算集群的运算能力的测试工具;Linpack测试出的计算结果后采用的单位是MFlops, GFlops或者TFlops的(每秒浮点运算百万次,亿次或万亿次)来于计算机理论计算峰值进行比较。

剑桥系统运行LINPACK基准比预期时间早了4小时。该系统是运行在一个有18TFlops运算能力的QLogic InfiniBand网络上的。这一性能足够让剑桥大学在超级计算机500强排行榜上排名第20位。

剑桥大学高性能计算总监Paul Calleja说:“包括HCA、导向器和交换机在内的QLogic InfiniBand网络给我们带来最低的延迟、高带宽和高性能的内部联接,而且这一切都是在一个可承受的价格范围之内。此外,配置这样一个解决方案如此迅速,使得我们顺利地完成了相关测试,并在全球HPC排名中取得了第20位的成绩。”