11.4 系统方案设计

11.4.1 系统总体结构图

根据数据中心形式的信息数据库建设需求分析,系统总体结构(图11-2)描述如下:

图 11-2 数据中心建设概况

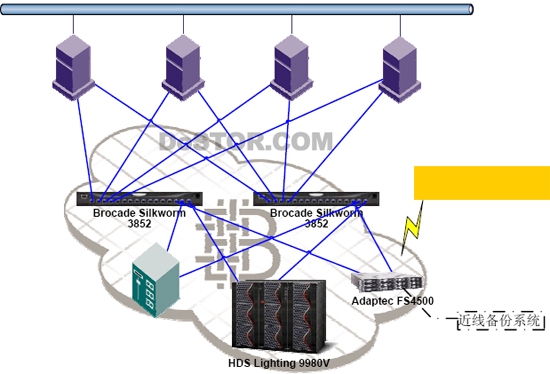

本项目的存储网络架构图,通过SAN 能够将多种数据应用全面整合起来,其中后端的阵列是整个系统的核心,所有的业务数据都存在该阵列中,因此阵列本身需要完全冗余架构和极高的吞吐性能;SAN 网络采用dual Fabric 设计,采用两台交换机构成冗余的存储网络;每台主机(关键业务)可以采用两块(甚至更多)HBA 跨接到两台SAN 交换机上,做的主机到存储接口冗余;主机层采用HA 配置,因此整个系统是高效而全冗余的。同时也能够平滑过渡到下阶段的容灾系统。

备份系统也跨接到SAN 网络上,这样所有的备份工作可以大大减轻对于生产网络的影响,主机直接通过SAN 将数据读出并写到带库,完全采用FC/SCSI 协议。

在上述架构中,后端的磁盘阵列采用高性能磁盘阵列,作为综合存储磁盘阵列。该磁盘阵列代表当时行业的最佳性能、100%数据可用性,以及功能丰富的管理软件。

11.4.2 数据库服务器设计

11.4.2.1 数据库系统结构

数据库服务平台主要采用动态分区、多机集群、并行数据库等技术,实现多台数据库主机同时并行访问数据库,应用可以根据需求均衡到不同主机资源上同时工作,多机互为备份。这种机制依靠系统提供的系统硬件、操作系统集群软件、与数据库提供的并行技术来满足要求。数据库支持数据分区技术,通过数据库分区技术提高查询效率。同时,与数据库服务平台相配合,采用专用数据采集处理服务器,负责数据采集工作,各数据库的数据采取分别汇集,单点入库的数据更新策略。

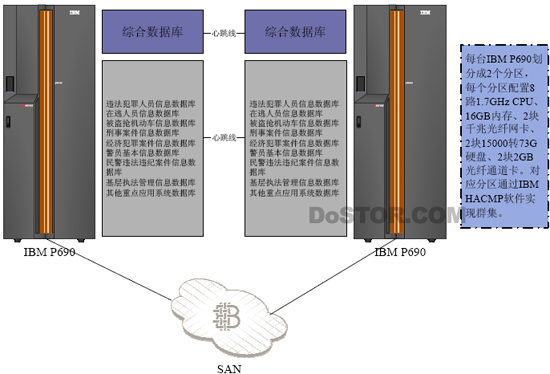

数据库服务器系统图如下:

图 11-3 数据服务器示意图,以IBM 产品为例

数据库服务器选用高性能UNIX 服务器,每台 高性能UNIX 服务器划分成2 个分区,每个分区配置8 路1.7GHz CPU、16GB 内存、2 块千兆光纤网卡、2 块15000 转73G 硬盘、2 块2GB 光纤通道卡。对应分区通过 HACMP 软件实现群集。

根据设计要求:“当前配置tpmC =(TPMC 基准值* 实际CPU 数目* 实际CPU 主频)/ (基准CPU 数目*基准CPU 主频)”

(768,839*16*1.7)/(32*1.7)=384,420tpmC

数据来源www.tpc.org

11.4.3 存储系统设计

11.4.3.1 存储系统结构

图 11-4 网络存储结构图

上图为数据存储部分的系统架构示意图。

整体架构采用SAN-存储局域网的架构搭建,分为主机、交换机和存储设备三个层面:

1、主机层面

前端服务器每台通过两块光纤卡(以下简称HBA 卡)跨接到两台光纤交换机上,构成冗余链路;

2、光纤交换机

利用两台16 口光纤交换机作为SAN 的骨干设备,连接主机和存储设备;

3、存储设备

主存储设备:核心磁盘阵列存储所有系统的数据。该磁盘阵列通过1 对(2 块)接口卡分别跨接到两台光纤交换机上,构成冗余链路

近线存储设备:近线备份目标磁盘阵列使用采用STAT 磁盘的廉价磁盘阵列,离线备份目标带库采用设计方案已有的带库。

11.4.3.2 主存储系统方案

目前存储区域网(SAN)是解决海量存储问题的主流解决方案,也是本项目建设要求的解决方案,同时也支持NAS 方式。数据中心形式的信息数据库建设数据库及其应用系统相关的数据库即将统一存储到大容量高性能的存储设备上,存储设备与主机群之间通过SAN光纤交换机互联(具有冗余联接),同时数据备份设备也通过光纤交换机联接以提高备份效率,减轻网络和主机的压力。

在本方案中,存储工程师使用高档全光纤磁盘阵列为主存储系统,从用户的投资、需求综合分析,推荐了极佳的性能价格比的产品,用户可以根据性能要求、扩展性要求、价格需求等因素来选择。

根据数据中心形式的信息数据库建设该设计的需求,为了提高主磁盘阵列的性能,在该设计中推荐配备15000RPM 的73GB 磁盘。

磁盘阵列在各方面均应充分扩展,并能够充分满足今后业务发展过程中数据迁移、系统容灾的要求:

1)硬件方面

所有重要部分均应在线扩容??前端接口、磁盘控制卡、缓存、磁盘等。

2)软件方面

可选择不同的软件实现性能优化、数据迁移和数据容灾等:

- 管理软件

- 安全控制软件

- 数据缓存化软件

- 性能管理套件

- 本地镜像软件

- 容灾软件

- 多链路负载均衡和故障切换软件

3)所有维护和扩容均应在用户现场、不中断应用的情况下完成

11.4.3.3 近线备份系统

传统的数据存储一般分为在线(On-line)存储及离线(Off-line)存储两级存储方式。所谓在线存储就是指将数据存放在磁盘系统上,而离线则是指将数据备份到磁带上。硬盘的优点是速度快,特别是随机访问能力强,但单位容量成本高,适合需要频繁访问的数据存储;磁带善于传输流式数据,介质与驱动器相分离的特性决定了其单位容量成本低廉,保存数据的安全性也较高,适合数据备份。

但随着数据量的猛增,这种只使用在线和离线两级存储的策略已经不能适应企业的需求。一方面,用户有越来越多的数据在一定时期内仍需要访问,如果备份到磁带上,则读取的速度太慢,而保持在线状态,又会因访问频度不高而占用宝贵的存储空间;另一方面,用户要求“备份窗口”越来越小,备份设备要具有更快的速度,以缩短备份时间,而带基设备与盘基设备相比还不够快。

由此产生了数据的分级存储管理(HierarchicalStorageManagement,HSM)。分级存储管理是一种将非在线存储与在线存储融合的技术。它以数据生命周期的不同阶段来决定存储的位置,从而在在线存储与离线存储之间诞生了第三种存储方式—-近线(Near-line)存储,使存储网络从“在线–离线”的两级架构向“在线–近线–离线”的三级架构演变。近线存储的特点是性能接近在线存储,而成本接近离线存储。

根据大型信息数据库存储系统分析结果,存储容量约为16TB,考虑适当冗余和“快照”备份,存储阵列实配容量应大于20TB,存储阵列最大扩展容量应不低于64TB。

基于存储区域网技术,满足数据中心形式的信息数据库建设数据库和应用系统相关数据库,以及运行于其上的业务系统、查询系统、数据分析系统的要求,必须增强数据存储核心,选择高性能存储阵列,LUN 数量应≥2048,系统IOPS≥240000(吞吐量大于1540 M/S)。

其基本性能需求分析如下:

1、在存储系统中,处理器主要完成I/O 处理、Cache 控制管理、数据传输控制以及一些智能化的软件运行功能,处理器的能力直接影响到整个存储系统的性能。考虑到不同厂商存储所采用的CPU 性能差异较大、主处理器所承担的任务也有所区别,应在给出实际处理器配置数量的同时给出性能指标、承载任务分析,CPU 实配数量不低于16 个。

2、磁盘本身性能也决定存储系统整体性能,通常磁盘性能以转速、寻道时间等技术指标衡量,考虑到性价比,推荐采用15K rpm 的磁盘。

3、对于数据库等大数据量访问应用,缓存越大,性能越好,本项目实配存储容量应与Cache 的容量配置成比例配置,按大于16GB 考虑,最大可扩展到128GB。

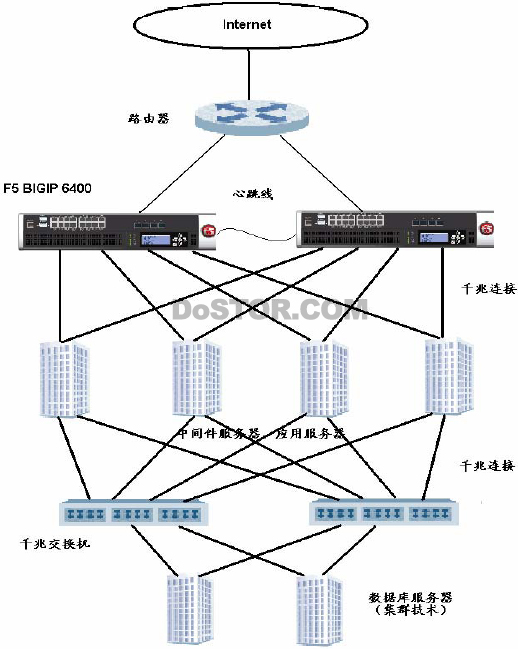

11.4.4 负载均衡系统设计

考虑到系统的高并发访问量和系统应用需求的快速增长,项目建设明确制定了Web 服务层、应用服务层规划:走横向扩容、持续发展的道路,以服务器群、交易中间件满足不断增长且趋于复杂化的用户访问请求、提高访问处理和响应能力。遵循这一规划,Web 信息发布层、应用服务层考虑了以下因素:

1、支持横向扩容的负载均衡器。

2、提高系统可靠性的集群或热备技术应用

3、各层服务器本身构架、性能、配置要满足需求。

本系统中采用业界领先的全千兆负载均衡解决方案:(千兆光纤端口+千兆以太网端口)方案中,可以采用两台 IP 应用交换机BIGIP 安全流量交换机6400 作为冗余,为中间件服务器和应用服务器做负载均衡,并且SSL 加速功能。所有服务器均配置冗余千兆网卡与两台BIGIP6400 相连,这样无论是其中的一个服务器网卡故障还是一台BIGIP6400 故障,都不影响业务的正常运行。

图11-5 负载均衡设计图

方案的特色:

- 实时监控服务器应用系统的状态,并智能屏蔽故障应用系统

- 实现多台服务器的负载均衡,提升系统的可靠性

- 提供服务器在线维护和调试的手段

- 可以对服务器提供流量限制和安全保护

11.4.5 应用服务器、浏览服务器和数据处理前置机设计

应用服务器层主要负责业务逻辑处理,用户请求的连接处理和数据库端或其他应用系统的连接处理,以及业务处理过程实现。用户多层体系结构要求应用服务器与Web 服务器物理独立,考虑到应用服务器对处理能力、系统稳定性的要求均大大高于数据表现层,关键应用采用Unix 服务器,其他应用可考虑刀片式微机服务器,建立多机集群环境。

本方案中间一的应用服务器采用中档UNIX 服务器,实配单台处理能力不低于70000tpmC,中档UNIX 服务器 采用4 路1.45GHz CPU(可扩≥8 路),8GB 内存(可扩≥64GB),73G 硬盘2 块,4 块千兆光纤网卡。

浏览服务器群和数据处理前置机采用工业级刀片服务器,每台配置2 路Xeon MP2.7GHz CPU(可扩≥4 路),8GB 内存,2 块73GB 硬盘,2 块2GB 千兆光纤通道卡。系统架构中该层面应不少于2 台小型机,4 台微机服务器,以满足峰值下信息访问的需求。